La sensibilidad de un sensor es una medida clave para evaluar su rendimiento y su capacidad para detectar y responder a cambios en una determinada variable. En este artículo, exploraremos qué es la sensibilidad de un sensor, cómo se calcula y por qué es importante en diferentes aplicaciones. Desde la detección de temperatura hasta la medición de presión y mucho más, comprender la sensibilidad de un sensor es fundamental para garantizar mediciones precisas y confiables. Sigue leyendo para descubrir todo lo que necesitas saber sobre este concepto fundamental en el mundo de los sensores.

Contenidos

Sensibilidad cruzada del sensor

La sensibilidad cruzada del sensor se refiere a la capacidad de un sensor para detectar y responder a estímulos o señales que no son el objetivo principal de medición. Esto significa que el sensor puede ser afectado por fuentes de interferencia externas o internas, lo que puede generar mediciones inexactas o errores en los resultados.

Algunos factores que pueden causar sensibilidad cruzada en un sensor incluyen la interferencia electromagnética, la interferencia térmica, la interferencia óptica y la interferencia química. Estas interferencias pueden provenir de fuentes cercanas al sensor, como otros equipos electrónicos o fuentes de radiación, o pueden ser el resultado de condiciones ambientales específicas.

La sensibilidad cruzada del sensor puede ser minimizada o eliminada mediante el uso de técnicas de blindaje, filtrado y aislamiento adecuados. Esto implica la utilización de materiales y diseños que ayuden a bloquear o reducir la interferencia externa, así como la implementación de circuitos de filtrado y acondicionamiento de señales para eliminar o atenuar las señales no deseadas.

Es importante tener en cuenta la sensibilidad cruzada del sensor al seleccionar y utilizar un sensor en una aplicación específica. La sensibilidad cruzada puede afectar la precisión y confiabilidad de las mediciones, por lo que es necesario evaluar y comprender las características y especificaciones del sensor antes de su implementación.

Sensibilidad de un instrumento de medición

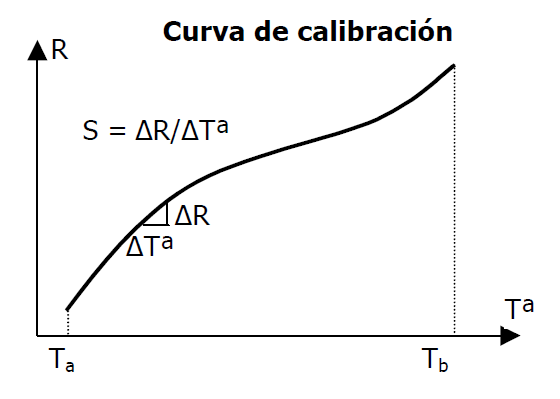

La sensibilidad de un instrumento de medición se refiere a la capacidad que tiene dicho instrumento para detectar y medir pequeños cambios en la magnitud que se está midiendo. Cuanto mayor sea la sensibilidad de un instrumento, más pequeñas serán las variaciones que podrá detectar y medir.

La sensibilidad se expresa generalmente en términos de la relación entre el cambio en la salida del instrumento y el cambio correspondiente en la magnitud que se está midiendo. Por ejemplo, si un instrumento tiene una sensibilidad de 0.1 unidades por voltio, significa que por cada voltio de cambio en la magnitud medida, la salida del instrumento cambiará en 0.1 unidades.

Es importante tener en cuenta que la sensibilidad de un instrumento no debe confundirse con su precisión. La sensibilidad se refiere a la capacidad de detectar cambios, mientras que la precisión se refiere a la capacidad de obtener mediciones exactas y cercanas al valor verdadero.

La sensibilidad de un instrumento puede verse afectada por diversos factores, como la calidad y calibración del instrumento, la tecnología utilizada en su construcción, el rango de medición y la resolución del instrumento.

Exactitud de un sensor: todo lo que necesitas saber.

La exactitud de un sensor se refiere a su capacidad para proporcionar mediciones precisas y confiables.

Es una medida de qué tan cerca está la lectura del sensor del valor verdadero o correcto. Para evaluar la exactitud de un sensor, se comparan las mediciones del sensor con un estándar de referencia conocido.

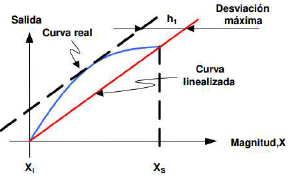

Algunos factores que pueden afectar la exactitud de un sensor incluyen el error de calibración, el ruido, la linealidad y la estabilidad a largo plazo. El error de calibración se produce cuando el sensor tiene una desviación sistemática de la lectura esperada. El ruido se refiere a las fluctuaciones aleatorias en las mediciones del sensor, que pueden afectar la precisión. La linealidad se refiere a qué tan bien la respuesta del sensor se ajusta a una línea recta. La estabilidad a largo plazo se refiere a la capacidad del sensor para mantener su exactitud con el tiempo.

La exactitud de un sensor se expresa generalmente como un porcentaje del rango de medición o como una cantidad absoluta. Por ejemplo, un sensor de temperatura puede tener una exactitud de ±0.5 grados Celsius, lo que significa que las mediciones del sensor pueden desviarse hasta 0.5 grados Celsius del valor verdadero. También es común expresar la exactitud como un porcentaje del rango de medición, por ejemplo, ±1% del rango.

Es importante tener en cuenta que la exactitud de un sensor puede variar en diferentes condiciones de operación. Por ejemplo, la exactitud de un sensor de presión puede verse afectada por la temperatura ambiente o la humedad. Por lo tanto, es importante comprender las condiciones en las que se utilizará el sensor y considerar cómo estos factores pueden afectar su exactitud.

La sensibilidad de un sensor se refiere a su capacidad para detectar cambios o variaciones en una magnitud física o química. Es importante tener en cuenta que la sensibilidad de un sensor puede variar según el tipo de sensor y la aplicación específica.

Si estás interesado en conocer la sensibilidad de un sensor, te recomendaría que consultes la hoja de especificaciones técnicas del fabricante. Allí encontrarás información detallada sobre las características del sensor, incluyendo su sensibilidad.

Además, es importante considerar otros factores como el rango de medición del sensor, la resolución, la precisión y la estabilidad. Estos aspectos te ayudarán a tomar una decisión informada sobre qué sensor es el más adecuado para tu aplicación específica.

Recuerda que la sensibilidad de un sensor es solo uno de los muchos factores a considerar al elegir un sensor. Es importante tener en cuenta todas las características relevantes y realizar pruebas y evaluaciones adicionales antes de tomar una decisión final.